A NVIDIA e a Lakera AI introduziram uma estrutura unificada e inovadora de segurança e proteção projetada para enfrentar os desafios emergentes apresentados por agentes autônomos de IA em ambientes corporativos.

Este esforço colaborativo representa um avanço significativo para tornar os sistemas de IA de sistemas de agente capazes de planejamento independente, uso de ferramentas e execução de tarefas em várias etapas mais seguros e protegidos para implantação no mundo real.

A investigação, liderada por cientistas de ambas as organizações, reformula a segurança e a protecção como propriedades emergentes que surgem de interacções dinâmicas entre múltiplos componentes em sistemas de agentes, em vez de atributos fixos de modelos individuais.

Esta perspectiva é crucial porque os sistemas de agência operam de forma fundamentalmente diferente dos modelos de linguagem tradicionais.

Eles podem invocar ferramentas, acessar dados externos, tomar decisões autônomas e interagir com os usuários em diversas etapas, criando novas superfícies de ataque e possíveis modos de falha que as abordagens de avaliação tradicionais podem ignorar.

Lacuna crítica na segurança da AI Agentic

Ao contrário do isolado grandes modelos de linguagem (LLMs) que passaram por extensas avaliações de segurança e proteção, os sistemas agentes introduzem novos riscos através de sua arquitetura composicional.

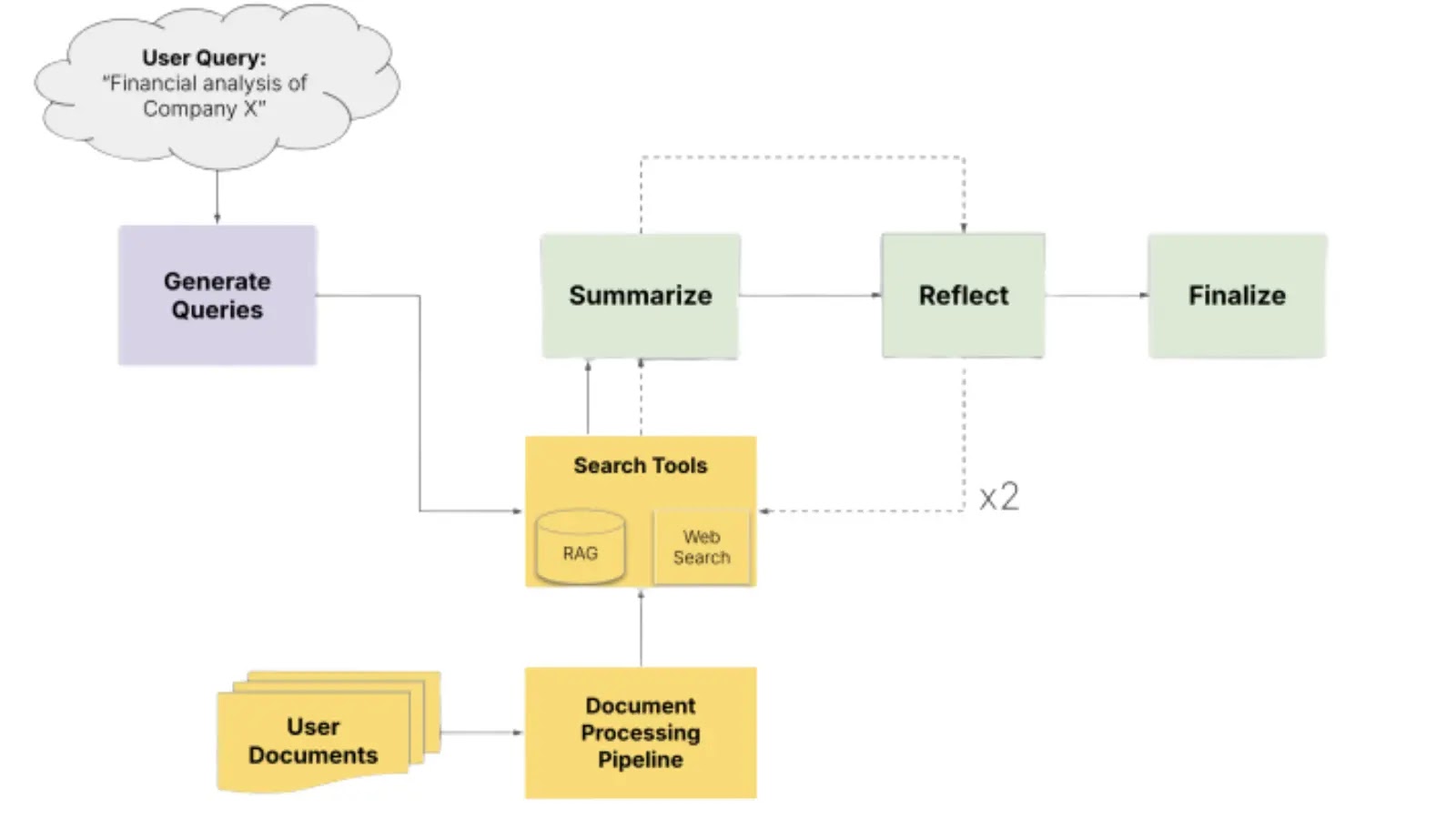

O sistema em teste pode ter vários subagentes que podem invocar ferramentas e APIs, consultar RAG e interagir com um ambiente externo.

A estrutura identifica riscos agentes únicos, incluindo uso indevido de ferramentas, cadeias de ação em cascata, amplificação de controle não intencional e interações multiagentes que não podem ser avaliadas adequadamente usando apenas métricas de segurança convencionais.

Os pesquisadores propõem que a segurança e a proteção sejam examinadas através de uma lente unificada centrada na prevenção de danos ao usuário.

“Segurança e proteção não são apenas atributos fixos de modelos individuais, mas também propriedades emergentes decorrentes das interações dinâmicas entre modelos, orquestradores, ferramentas e dados dentro de seus ambientes operacionais”, enfatiza o documento.

A estrutura apresenta uma taxonomia de risco operacional que unifica as preocupações tradicionais de segurança e proteção com riscos exclusivamente agentes, priorizados de acordo com seu impacto e explorabilidade.

Na sua essência está uma metodologia de avaliação dinâmica que utiliza Agentes de IA para descoberta, avaliação e mitigação de riscos.

Em vez de depender apenas de testes estáticos de pré-lançamento, a estrutura emprega avaliação contínua e consciente do contexto por meio de equipes vermelhas orientadas por IA em sandbox.

Os pesquisadores introduziram o Agent Red Teaming via Probes (ARP), uma metodologia inovadora que permite testes de segurança direcionados em pontos específicos ao longo de um fluxo de trabalho de agente.

Essa abordagem permite que os desenvolvedores entendam como as ameaças se propagam através dos componentes do sistema, independentemente das alterações upstream, proporcionando visibilidade granular dos pontos fracos de segurança.

Assistente de pesquisa AI-Q da NVIDIA

A eficácia do quadro foi demonstrado por meio de um extenso estudo de caso do AI-Q Research Assistant (AIRA) da NVIDIA, uma ferramenta de pesquisa sofisticada que sintetiza informações de bancos de dados corporativos e pesquisas na web.

O estudo incluiu mais de 10.000 execuções realistas de ataques e defesa em 22 cenários de ameaças distintos, abrangendo nove categorias de risco.

Notavelmente, a pesquisa revelou padrões diferenciais de propagação de ataques: enquanto os ataques diretos de entrada do usuário foram amplificados através do pipeline de processamento, os ataques de fontes de dados externas foram progressivamente atenuados em insights que informam diretamente as estratégias de defesa direcionadas.

A estrutura alcançou uma redução de risco de aproximadamente 50% por meio de proteções direcionadas e demonstrou como monitorar continuamente as melhorias de segurança nas versões dos agentes.

NVIDIA e a Lakera AI lançaram o conjunto de dados de segurança de agentes Nemotron-AIQ contendo mais de 10.000 arquivos de rastreamento de seus experimentos, permitindo que a comunidade de pesquisa avance na avaliação de segurança de agentes.

A ênfase da estrutura em defesas contextuais e em camadas, em vez de medidas de segurança gerais, representa uma abordagem pragmática para manter uma segurança robusta e um desempenho aceitável do sistema.

Esta estrutura colaborativa representa um marco importante no estabelecimento de metodologias práticas para proteger sistemas autônomos de IA, abordando o que tem sido uma lacuna crítica na orientação de implantação de IA empresarial.

Siga-nos emGoogle Notícias,LinkedIneXpara obter atualizações instantâneas e definir GBH como fonte preferencial emGoogle.