Os pesquisadores da Tenable encontraram 7 novas vulnerabilidades no ChatGPT da OpenAI, colocando os usuários em risco de roubo de dados e violações de segurança por meio de novos ataques a sistemas de IA apelidados de HackedGPT.

Falhas conhecidas como HackedGPT foram fundar durante o teste do ChatGPT-4o da OpenAI e alguns persistem no ChatGPT-5. A OpenAI corrigiu alguns problemas, mas outros permanecem, arriscando a exploração. A Tenable relata que essas fraquezas podem permitir que invasores acessem secretamente dados pessoais, como bate-papos e memória salvos, sem que os usuários percebam.

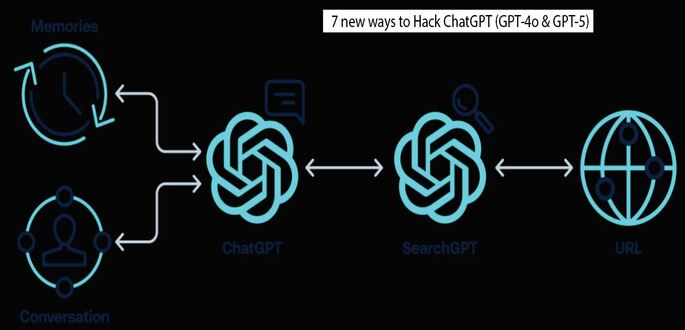

Uma nova IA explorar chamada de injeção indireta de prompt permite que os invasores ocultem instruções maliciosas em páginas da web ou comentários confiáveis. Quando o ChatGPT se envolve com esse conteúdo, ele segue involuntariamente os comandos incorporados.

A pesquisa da Tenable descobriu que esses ataques podem ocorrer silenciosamente, mesmo sem interação do usuário. Em ataques de “0 cliques”, simplesmente fazer uma pergunta ao ChatGPT pode desencadear a exploração, enquanto os ataques de “1 clique” ativam comandos maliciosos por meio de um único clique do usuário em um link.

A injeção de memória persistente é um método preocupante que permite que instruções prejudiciais sejam armazenadas na memória de longo prazo do ChatGPT. Esses prompts maliciosos podem persistir entre as sessões, extraindo dados confidenciais até que sejam excluídos manualmente.

Moshe Bernstein (fotod), engenheiro de pesquisa sênior da Tenable, disse que a descoberta destaca uma falha fundamental em como os grandes modelos de linguagem determinam a confiança.

“Individualmente, essas falhas parecem pequenas – mas juntas formam uma cadeia de ataque completa, desde injeção e evasão até roubo e persistência de dados”, disse Bernstein. “Isso mostra que os sistemas de IA não são apenas alvos em potencial; eles podem ser transformados em ferramentas de ataque que coletam silenciosamente informações de bate-papos ou navegação diários.”

As sete vulnerabilidades identificadas incluem:

Injeção indireta de prompt por meio de sites confiáveis – Instruções maliciosas ocultas em conteúdo online legítimo.

Injeção de prompt de 0 clique – Comprometimento acionado automaticamente durante a navegação ou pesquisa.

Injeção de prompt com 1 clique – Ativação por meio de links aparentemente seguros.

Desvio do mecanismo de segurança – Exploração de URLs de wrapper confiáveis para disfarçar sites maliciosos.

Injeção de conversa – Usando o próprio sistema de navegação do ChatGPT para inserir comandos em bate-papos em andamento.

Ocultação de conteúdo malicioso – Ocultar instruções prejudiciais dentro do código formatado ou markdown.

Injeção de memória persistente – Inserção de instruções duradouras na memória de longo prazo para vazamento contínuo de dados.

As vulnerabilidades exploradas podem permitir que invasores insiram comandos ocultos, roubem informações de históricos de bate-papo ou serviços vinculados e manipulem respostas para espalhar desinformação.

Os pesquisadores da Tenable compartilharam com responsabilidade suas descobertas e alertaram que outros sistemas de IA com recursos de navegação ou memória podem ter vulnerabilidades semelhantes. Eles aconselham os desenvolvedores de IA a isolar e colocar esses recursos em sandbox, validar filtros de segurança e aplicar princípios de confiança zero nas entradas de IA.

Para equipes de segurança, a Tenable aconselha tratar os modelos de IA como superfícies de ataque ao vivo. As ações recomendadas incluem:

Monitoramento de integrações de IA em busca de sinais de manipulação ou vazamento de dados.

Testar defesas contra tentativas de injeção e exfiltração.

Implementação de controles de governança e classificação de dados em torno do uso da IA.

Bernstein disse que as descobertas devem servir como um alerta para a indústria.

“Esta pesquisa não é apenas sobre expor falhas – é sobre mudar a forma como protegemos a IA”, disse ele. “Pessoas e organizações precisam assumir que as ferramentas de IA podem ser manipuladas e projetar controles de acordo.” Isso significa governança, proteção de dados e testes contínuos para garantir que esses sistemas funcionem a nosso favor, não contra nós.”

À medida que a IA generativa se torna parte dos sistemas empresariais e governamentais, o HackedGPT enfatiza um fato importante: os benefícios da IA precisam de fortes medidas de segurança.